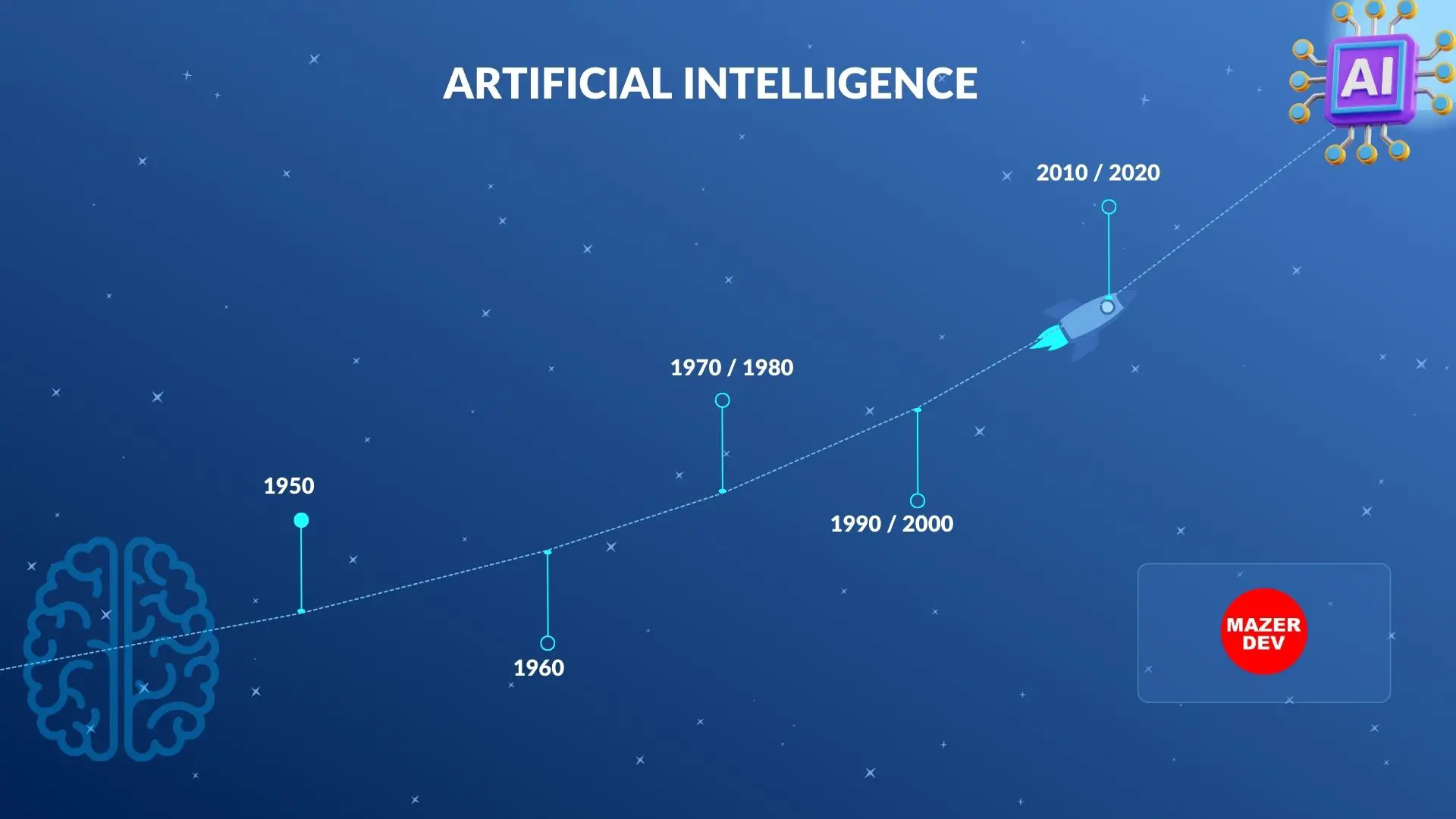

Esta é uma linha do tempo detalhada da história da Inteligência Artificial (IA), destacando eventos significativos, avanços e desenvolvimentos desde seus primórdios:

1943: Warren McCulloch e Walter Pitts desenvolvem o primeiro modelo matemático de um neurônio artificial, lançando as bases para redes neurais.

1950: Alan Turing propõe o Teste de Turing, um método para determinar se uma máquina exibe um comportamento inteligente indistinguível do de um humano.

1956: John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon organizam a Conferência de Dartmouth, marcando o nascimento da IA como campo de estudo.

1956: O pesquisador da IBM Arthur Samuel desenvolve um programa de jogo de damas, que está entre os primeiros programas de IA e um esforço pioneiro em aprendizado de máquina. O programa aprende a melhorar sua jogabilidade jogando contra si mesmo e refinando sua estratégia ao longo do tempo.

1956-1974: O entusiasmo inicial pela pesquisa de IA leva a desenvolvimentos significativos, incluindo a linguagem de programação Lisp de McCarthy, o Perceptron de Rosenblatt e o General Problem Solver de Newell e Simon.

1964: O programa STUDENT de Danny Bobrow demonstra a capacidade de resolver problemas de álgebra de palavras, mostrando as primeiras capacidades de compreensão de linguagem natural em IA.

1965: Joseph Weizenbaum desenvolve ELIZA, um chatbot que simula um psicoterapeuta rogeriano, ilustrando o potencial da IA no processamento de linguagem natural.

1969: Marvin Minsky e Seymour Papert publicam “Perceptrons”, levantando dúvidas sobre as capacidades das redes neurais e mudando o foco da pesquisa para IA simbólica e sistemas especialistas.

1972: A linguagem de programação PROLOG é desenvolvida por Alain Colmerauer e Philippe Roussel, tornando-se uma escolha popular para aplicações de IA em programação lógica e representação de conhecimento.

1974-1980: A pesquisa em IA enfrenta um período de financiamento reduzido e ceticismo conhecido como o “inverno da IA”, à medida que as limitações dos primeiros sistemas de IA se tornam aparentes.

Década de 1980: Sistemas especialistas, como MYCIN e XCON, ganham destaque nesse período, demonstrando o potencial da IA em domínios de conhecimento especializados.

1986: O algoritmo de backpropagation, desenvolvido por Geoffrey Hinton, David Rumelhart e Ronald Williams, revitaliza o interesse em redes neurais ao permitir um treinamento mais eficaz de perceptrons multicamadas.

Década de 1990: Aprendizado de máquina e métodos estatísticos ganham popularidade na pesquisa de IA, com o desenvolvimento de algoritmos como Support Vector Machines e árvores de decisão.

1990: Rodney Brooks introduz o conceito de robótica baseada em comportamento, promovendo uma abordagem de baixo para cima para IA e robótica que enfatiza a importância da interação com o ambiente.

1992: Gerald Tesauro desenvolve o TD-Gammon, um programa de jogo de gamão que usa aprendizado por reforço e redes neurais para alcançar o nível de jogo de especialistas, demonstrando o potencial dessas técnicas para aprender com a experiência.

1995: Richard Wallace cria o chatbot A.L.I.C.E (Artificial Linguistic Internet Computer Entity), baseado no programa ELIZA anterior, apresentando avanços no processamento de linguagem natural e IA conversacional.

1997: O Deep Blue da IBM derrota o campeão mundial de xadrez Garry Kasparov, marcando um marco na capacidade da IA de dominar jogos estratégicos complexos.

1997: A primeira versão da RoboCup, uma competição internacional de robótica focada em robôs que jogam futebol, acontece no Japão, promovendo pesquisas em IA, robótica e sistemas multiagentes.

1999: Yann LeCun e seus colaboradores apresentam a rede neural convolucional LeNet-5 (CNN) para reconhecimento de manuscrito, abrindo caminho para futuros avanços em aprendizado profundo e visão computacional.

2000: O rápido desenvolvimento da World Wide Web durante este período alimenta a pesquisa em tópicos de IA, como recuperação de informações, mineração na web e tecnologias da web semântica.

2001: A primeira versão do projeto Reconhecimento Automático de Fala em Condições Adversas (AURORA) é lançada para melhorar a tecnologia de reconhecimento de fala em ambientes desafiadores, levando a avanços significativos nesta área.

2004: Realiza-se o primeiro DARPA Grand Challenge, uma competição para veículos autónomos, que estimula a investigação e o desenvolvimento em automóveis autónomos e robótica.

2004: A IBM apresenta o IBM WebFountain, uma plataforma de análise de texto e mineração de dados em larga escala que utiliza técnicas de IA, como processamento de linguagem natural e aprendizado de máquina para analisar grandes quantidades de dados não estruturados na web.

2005: Sebastian Thrun, Michael Montemerlo e sua equipe na Universidade de Stanford vencem o segundo DARPA Grand Challenge com seu veículo robótico Stanley, mostrando avanços em navegação autônoma e fusão de sensores.

2006: Geoffrey Hinton e seus colaboradores cunham o termo “deep learning” e introduzem técnicas para o treinamento de redes neurais profundas, preparando o terreno para um ressurgimento na pesquisa de redes neurais.

2007: Fei-Fei Li, Kai Li e Li-Jia Li lançam o conjunto de dados ImageNet, um banco de dados visual em grande escala que se torna um recurso crucial para benchmarking e impulsionar o progresso em visão computacional e aprendizado profundo.

2009: A primeira versão do Kinect, um dispositivo de detecção de movimento desenvolvido pela Microsoft para o console de jogos Xbox, é lançada, demonstrando avanços na estimativa de pose humana em tempo real e reconhecimento de gestos.

Anos 2010: A ascensão do big data, o aumento do poder computacional e os avanços nos algoritmos de aprendizagem profunda levam a avanços significativos na IA, particularmente em áreas como visão computacional, reconhecimento de fala e processamento de linguagem natural.

2011: O sistema Watson AI da IBM ganha o Jeopardy! game show contra campeões humanos, mostrando suas proezas em compreensão de linguagem natural, recuperação de conhecimento e aprendizado de máquina. Esse sucesso destaca o potencial da IA em uma ampla gama de aplicações, incluindo saúde, finanças e atendimento ao cliente.

2012: Alex Krizhevsky, Ilya Sutskever e Geoffrey Hinton alcançam resultados de última geração no desafio ImageNet usando uma rede neural convolucional profunda (CNN), alimentando o interesse em aprendizado profundo para tarefas de visão computacional.

2013: A DeepMind, uma empresa líder em pesquisa de IA fundada por Demis Hassabis, Shane Legg e Mustafa Suleyman, apresenta o algoritmo DQN, que combina aprendizado profundo e aprendizado por reforço para alcançar desempenho de nível humano em jogos Atari.

2014: O Google adquire a DeepMind, uma empresa líder em pesquisa de IA que mais tarde desenvolve o programa AlphaGo, que derrota o jogador campeão mundial Go em 2016.

2014: A IBM lança o Watson Developer Cloud, um conjunto de APIs e serviços que permitem aos desenvolvedores construir aplicativos alimentados por IA usando a tecnologia Watson da IBM. Essa iniciativa leva recursos de IA para uma gama mais ampla de indústrias e aplicações.

2014: Ian Goodfellow e seus colaboradores apresentam Generative Adversarial Networks (GANs), uma nova estrutura de aprendizado profundo para gerar imagens realistas, que desde então tem sido aplicada a vários domínios, como arte, design e aumento de dados.

2015: A Microsoft lança a primeira versão do Microsoft Cognitive Toolkit (anteriormente conhecido como CNTK), uma estrutura de aprendizado profundo de código aberto que facilita o desenvolvimento de modelos de IA em várias plataformas.

2016: O AlphaGo do Google DeepMind derrota o campeão mundial de Go Lee Sedol em uma partida de cinco jogos, demonstrando avanços significativos na capacidade da IA de dominar jogos de estratégia complexos.

2016: A IBM apresenta o Project Debater, um sistema de IA que pode se envolver em debates ao vivo com humanos analisando grandes quantidades de dados de texto, formulando argumentos e apresentando-os de maneira coerente. Este projeto mostra avanços na compreensão de linguagem natural e recursos de raciocínio da IA.

2017: Pesquisadores do Facebook AI Research (FAIR) desenvolvem a estrutura de detecção de objetos “Detectron”, que se torna uma ferramenta amplamente utilizada para tarefas como detecção de objetos, segmentação semântica e estimativa de pose humana.

2018: O modelo de linguagem GPT-2 da OpenAI demonstra capacidades impressionantes na geração de texto coerente e contextualmente relevante, destacando o potencial para modelos de linguagem em larga escala em IA.

2019: O Allen Institute for AI lança a biblioteca AllenNLP, uma plataforma de código aberto para pesquisa de processamento de linguagem natural, que fornece modelos, ferramentas e conjuntos de dados pré-treinados para várias tarefas de PNL.

2019: A IBM lança o kit de ferramentas AI Fairness 360, uma biblioteca de código aberto projetada para ajudar desenvolvedores e pesquisadores a detectar e mitigar vieses em modelos de IA. Este kit de ferramentas aborda a crescente preocupação com a justiça e a transparência nos sistemas de IA.

2020: A OpenAI lança o GPT-3, um modelo de linguagem ainda mais poderoso, mostrando sua capacidade de executar uma ampla gama de tarefas de processamento de linguagem natural com treinamento mínimo específico de tarefa.

2020: A IBM anuncia seu compromisso com o avanço da IA confiável, concentrando-se na transparência, justiça, robustez e explicabilidade no desenvolvimento de IA. Esse compromisso inclui o lançamento do kit de ferramentas AI Explainability 360, uma biblioteca de código aberto que fornece ferramentas para interpretar e explicar decisões de modelos de IA.

2021: O AlphaFold 2 do Google DeepMind alcança resultados inovadores na previsão da estrutura de proteínas, resolvendo um desafio de longa data na biologia molecular e abrindo novos caminhos para a descoberta de medicamentos e aplicações em biotecnologia.

Comentários